__瞬時に生まれる記事

__ワンクリックで完成するレポート

生成AIがもたらした革命は、企業コミュニケーションの常識を根底から覆しています。しかし、効率化の裏に潜む”正確性”という落とし穴を見逃してはなりません。AIが生成した記事やレポートの内容の半分に間違いがあるとしたら、それは恐ろしいことだと思いませんか?

この技術の急速な発展は「情報の正確性」という本質的な課題も浮き彫りにしています。

生成AIによるニュース要約には看過できない誤りが含まれる場合があると、イギリスの国営放送BBCが報告しました。こうした状況において、企業が築き上げた信頼とブランドの評判を維持するには、この新たな脅威を見極め、具体的な防衛策を講じることが不可欠です。

BBCの最新調査結果を中心に、生成AIがニュース要約を誤る背景と、誤要約を防ぐ具体的な対策について解説します。

BBC調査が示す「生成AIによる重大な誤要約

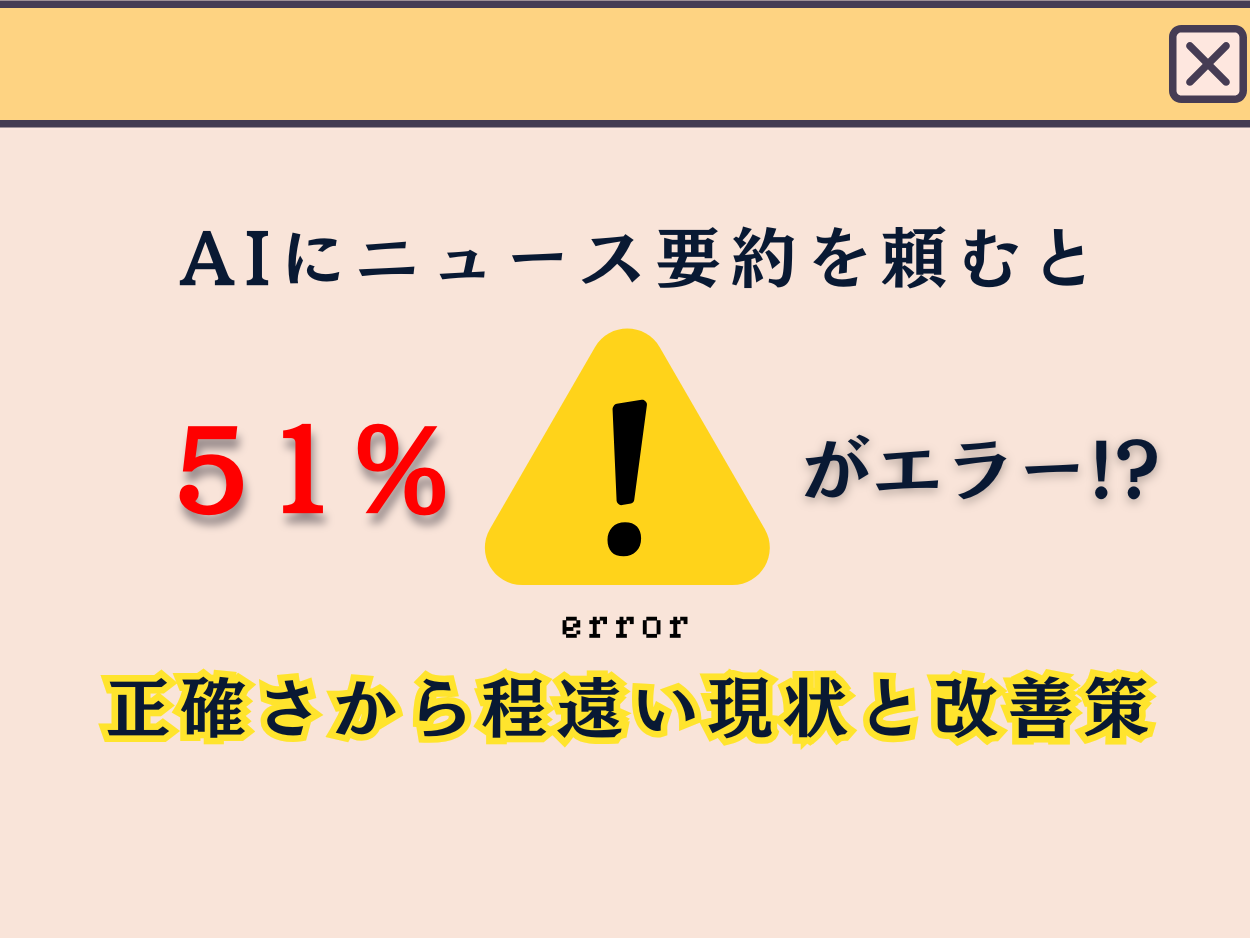

BBCが2024年12月に実施した注目すべき調査結果は、AI業界に重要な課題を提起しています。自社のニュース記事100本を主要生成AIチャットボットのChatGPT、Copilot、Gemini、Perplexity AIに要約させたところ、51%の回答に重大な問題が含まれていたのです。この数字が示す現実は、テクノロジーの進化と情報の正確性の間に生じた深刻な亀裂を浮き彫りにしました。

51%に重大な誤り:何が起きているのか

調査の詳細はさらに憂慮すべき実態を明らかにしました。要約結果の約19%には事実誤認や数字・日付の取り違えが確認され、13%では元記事に存在しない「架空の引用」が堂々と挿入されていたのです。これらのエラーは単なる技術的不具合ではなく、情報の正確性という根本的な価値を揺るがす問題です。

実際の不正確な要約には次のようなものが挙げられます。

- Geminiは、NHSは禁煙補助としてベイプ(電子タバコ)を推奨していないと誤って述べた。

- ChatGPTとCopilotは、かつて英国首相を務めたイギリスの保守党所属の政治家リシ・スナックとスコットランド自治政府首相を務めていたスコットランドの政治家ニコラ・スタージョンが退任後もまだ在任していると述べた。

- Perplexityが中東に関する記事でBBCニュースの引用を誤り、イランは当初 「自制 」を示し、イスラエルの行動は 「攻撃的 」と表現した。

この結果を目の当たりにしたBBCニュース・時事部門のCEO、デボラ・ターネス氏は「テック企業は火遊びをしているようなもの。彼らは自らの技術が引き起こす危険性を十分に理解していない」と厳しく警鐘を鳴らし、AIニュース要約を「撤回」するよう求めました。

「火遊び」の危険性:ニュース要約が引き起こす混乱

BBCニュース・時事部門CEOが用いた「火遊び(playing with fire)」という表現は、この問題への懸念の高まりを反映しています。ニュースは多くの人々の情報源として重要な役割を担っています。その要約に不正確さが含まれると、読者の理解や判断に一定の影響を与える可能性があります。これが広範囲に及べば、企業活動や政策決定、市場の動きにも影響を及ぼす可能性が出てきます。

BBCの調査結果は、こうしたリスクが単なる理論上の問題ではなく、既に一定の範囲で現実に生じている課題であることを示唆しています。技術の進化と情報の正確性のバランスを取りながら、慎重に対応を検討すべき段階だといえるでしょう。

(参考リンク:AI chatbots unable to accurately summarise news, BBC finds )

誤要約の暗黒面:AIが招いた3つの現実的脅威

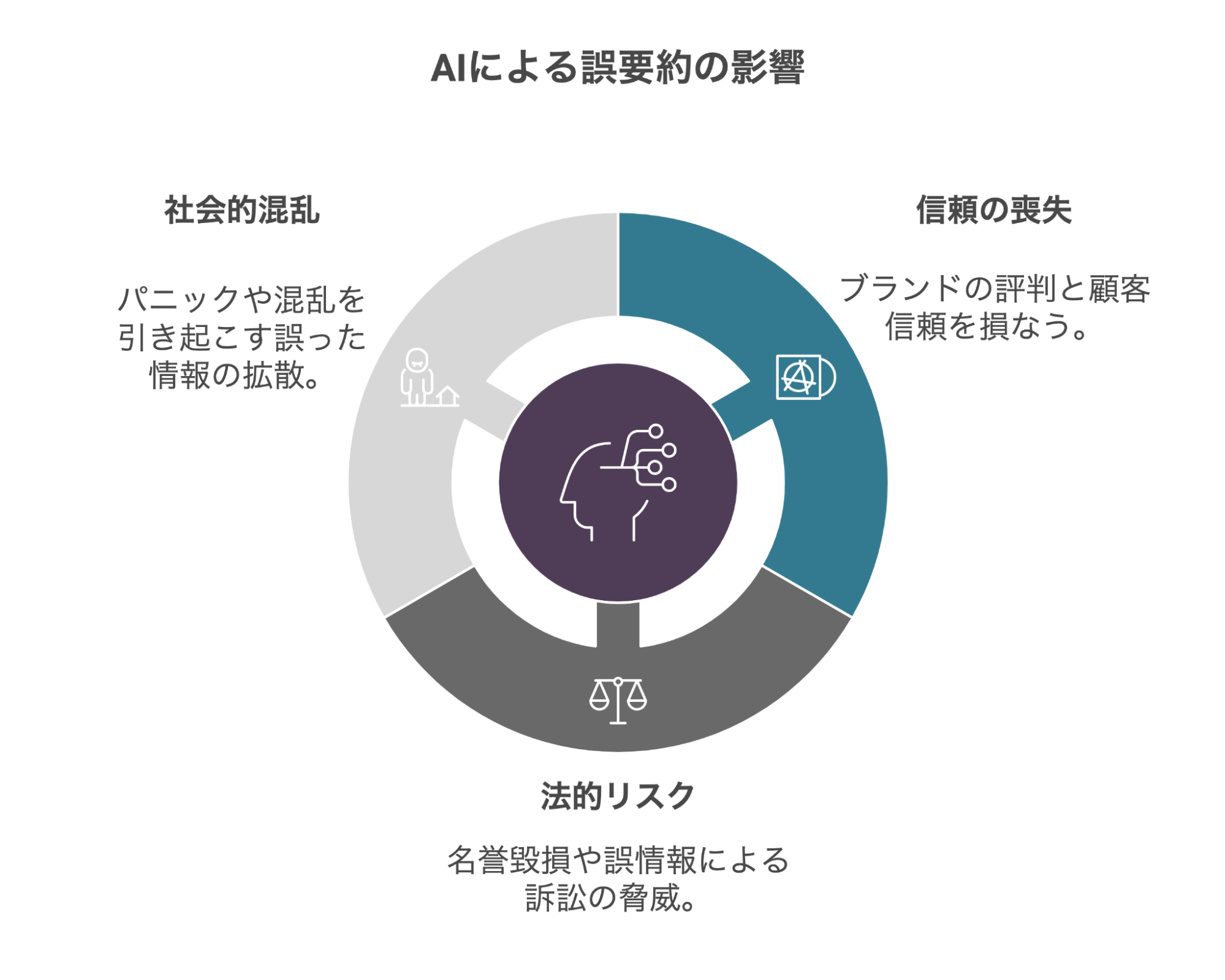

AIによる誤要約は私たちが想像する以上に危険な影響力を持っています。「ちょっとした誤り」と軽視できるレベルを超え、企業の存続や社会の安定までも脅かす可能性を秘めているのです。現実に起きた事例から浮かび上がる3つの警告信号を見てみましょう。

信頼失墜とブランドイメージの崩壊

テック界の巨人でさえも無傷ではいられません。2024年10月Apple社は革新的なニュース要約機能「Apple Intelligence」を華々しく発表したものの、わずか数週間で一時停止に追い込まれました。システムが生成した誤った見出し要約が次々と発生し、NGO(非営利組織)のRSF(国境なき記者団)からはこの機能の停止を求め、報道機関からも厳しい抗議を受けたのです。

何十年もかけて築き上げた「品質」と「信頼性」というAppleブランドの核心価値が、AIの不正確な要約によって一瞬にして揺らいでしまった瞬間でした。技術革新への焦りが、企業の最も大切な資産である「信頼」を危険にさらした教訓的事例と言えるでしょう。

名誉毀損や法的リスク

「AIが語る嘘が人生を変える」—オーストラリアの地方都市の市長の事例は、この言葉を象徴しています。過去に収賄で服役した事実がまったくないにもかかわらず、ChatGPTは「刑務所に入っていた」という完全な虚偽を堂々と生成。市長はOpenAI社に対して名誉毀損で法的措置を検討する事態にまで発展しました。

この出来事は、AIによる誤情報が仮想空間に留まらず、実在する人々の評判や社会的立場、ひいては企業や組織の存続にまで影響を及ぼす現実を私たちに突きつけています。誰もが情報の被害者になりうる時代の到来を告げる警鐘なのです。

社会不安・公共の混乱

もっとも恐ろしいのは、社会全体を混乱に陥れる可能性です。災害発生時、経済危機下、あるいは政治的緊張が高まる状況で、AIが生成した誤った情報が拡散されれば、その影響は雪崩のように広がります。

「避難所はあと3日分の食料しかない」「大手銀行が破綻寸前」「外国との衝突が切迫している」—こうした誤った要約が広がれば、パニック購入や市場暴落、さらには社会不安を引き起こす導火線となりかねません。事実と噂が混然一体となった”情報錯綜”状態は、冷静な判断を困難にし、社会全体を誤った方向へと導く危険性をはらんでいるのです。

BBCの衝撃的な調査結果を受けて「AIチャットボットによるニュース要約機能は停止すべきだ」という専門家の声が高まっているのは、私たちの情報環境が直面しているこの深刻なリスクへの危機感の表れと言えるでしょう。

(参考リンク: Apple suspends error-strewn AI generated news alerts)

(参考リンク: 豪市長、チャットGPT提訴も 「前科」誤情報の訂正要求)

生成AIの「盲点」:正確な要約を阻む3つの技術的壁

「最先端のAIがなぜ単純な要約すらできないのか?」と首をかしげる方も多いでしょう。しかし実は、生成AIには見えない構造的な弱点が存在するようです。最新の研究知見をもとに、その核心に迫ります。

統計的予測モデルの落とし穴

ChatGPTやCopilotなどの大規模言語モデルは、次の単語を”統計的”に予測して文章を生成する仕組みです。あくまでも過去データの文脈から導き出した「もっともらしい」文章を生成するだけであり、必ずしも”事実確認”が優先されるわけではありません。

自信満々に誤情報を出してしまう傾向は、まさにAIハルシネーション(幻覚)の象徴と言えます。

ファクトチェック機能の未熟さ

人間のジャーナリストなら、重要な数字や発言を必ず一次情報で確認します。しかし現在のAIには、たとえば医療や法的分野のニュースを要約する場合、公式サイトや信頼ある論文・統計を常に参照しないと致命的な誤報に至る可能性があります。玉石混交の情報を精査する能力もまたAIは不十分なのです。

現在の生成AIには、集めた情報を自律的に照合し、訂正する仕組みが十分に組み込まれていないため、生成した情報を鵜呑みにすることはできません。

最新の調査結果からもそのことは明白です。2025年2月ペンシルベニア州立大学の研究チームは、GenAI(生成AI)モデルがコンテンツの信頼性を評価する能力について実験しました。米国政治家のFacebook投稿約500件を用いた調査で、GPT-4o、Llama 3.1、Gemma2などの複数のAIモデルを分析しました。

主な発見として、GPT-4oが最も高い精度(F1スコア0.82)を示した一方、オープンソースのGemma2-9bも同等の性能を発揮しました。しかし全モデルの人間評価者との一致度は中程度にとどまったのです。

研究ではAIの推論パターンも分析され、AIは主に「情報の詳細度」「情報源の質」「言語の形式性」といった表面的特徴に依存し、真の真実性理解には限界があることが判明。特に、相互参照や詳細な情報を含んだ誤情報の検出は困難でした。

研究者らは、生成AIは単独のファクトチェックツールとしてではなく、人間の判断を補完するハイブリッドアプローチが最適だと結論づけています。

参照される情報が古い問題

多くのAIは、ユーザーの質問に答えるために信頼性の高いコンテンツを引用するよう設計されていますが、時系列を適切に判断できず、過去の記事や速報用のライブページを最新情報と誤認することがあります。

具体的なケースでは、最新のスコットランド独立問題に関する質問に対し、Copilotが2022年の古いBBCライブページを参照。当時首相だったニコラ・スタージョン氏による発言を「最近の動向」として伝え、「スタージョン首相は新たな独立キャンペーンを開始し、英国首相と交渉する用意があると述べた」と現在進行形で報告しました。

こうした時間的なミスマッチは、最新のBBC記事が利用可能であったにもかかわらず発生しており、なぜAIがより古い2022年の情報を優先的に選択するのかという根本的な課題が問題となっています。

(参考リンク: Hallucination is Inevitable:An Innate Limitation of Large Language Models)

(参考リンク: GenAI vs. Human Fact-Checkers: Accurate Ratings, Flawed Rationales)

(参考リンク: Representation of BBC News content in AI Assistants)

実際に行われている対策と改善策

誤要約の問題を放置すれば、読者の誤解を招くだけでなく、企業や報道機関の信用を損ねます。以下では、既にメディアや企業が実践している対策をいくつかご紹介します。

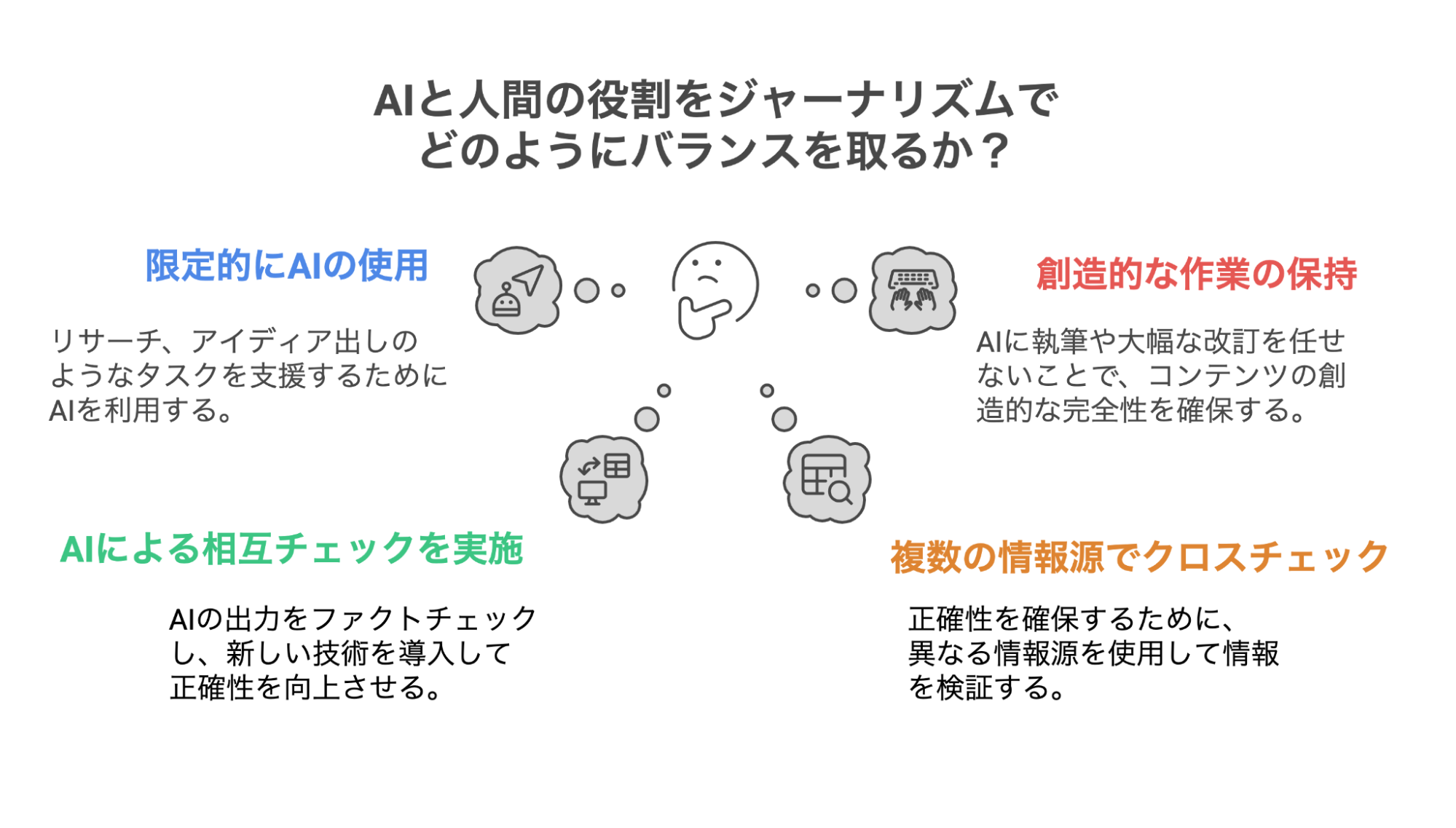

AI×ヒトによるファクトチェックと編集ガイドラインの徹底

米メディアSemaforの情報によると、ニューヨーク・タイムズは記者や編集者向けにAI研修プログラムを体系的に導入し、社内AIツール「Echo」を実装しました。このシステムは、情報の正確性を向上させながら、ジャーナリストの分析作業をサポートする設計となっています。

さらに、同社は編集業務におけるAIの適切な活用法と避けるべき使用例を具体的に示したガイドラインを文書と動画で配布。AI時代のジャーナリズムの質を維持するための組織的アプローチを強化しています。

AI活用と人間の役割・編集ガイドライン

奨励事項:SEOの見出し、要約、読者向けプロモーション、編集の提案、ブレインストーミング、調査、タイムズ紙自身の文書や画像分析

禁止事項:記事の初稿執筆、大幅な改稿といった「創造の核心」を生成AIに委ねること

さらに情報セキュリティと倫理面にも厳格な姿勢を示し、取材源の保護や著作権を守るため、第三者の機密情報や有料コンテンツをAIシステムに入力することを制限。これらの多層的なガイドラインは、革新的なツールを導入しながらも、ジャーナリズムの本質的価値を損なわないバランス感覚を反映したものといえるでしょう。

AI×AIの相互チェックや新技術の導入

2024年9月、Googleは大規模言語モデル(LLM)の回答を自動ファクトチェックする

「DataGemma」を発表しました。このシステムは二つの手法で事実の正確性を向上させます。

第一の「RIG」メソッドでは、回答案からチェック可能な部分を抽出し、「Data Commons」から統計データを検索。誤りを正確な情報に置き換え、出典を明示します。第二の「RAG」メソッドは、回答生成の段階で外部知識を参照する方式です。

実験結果では、RIG適用により回答の正確性が大幅に改善した一方で、Data Commons内に該当データがない場合や適切な検索クエリが作成できない場合の課題も指摘されています。技術的進歩は確かですが、完全な解決策にはまだ至っていません。

複数の独立ソースとのクロスチェック

誤要約リスクを低減するには、単一の情報源に依存せず、複数のニュースサイトや公的情報源を比較検証する「クロスチェック」が重要です。特に要約で引用を示す場合は、元記事URLを明記し、ユーザーが一次情報に直接アクセスできる環境を整えることが、AIの誤要約による誤解を防ぐ効果的な方法となります。

このように、テクノロジーの進化と人間の編集判断を組み合わせた多層的なアプローチが、AI時代の情報の信頼性を確保する鍵となっています。

(参考リンク: DataGemma: Using real-world data to address AI hallucinations)

(参考リンク:New York Times goes all-in on internal AI tools)

外注先選定の重要ポイント:品質を見極める視点

これまでの解説から明らかなように、生成AIによる記事作成には数多くの注意点があります。しかし、AI技術が急速に普及している現状では、コンテンツ制作を外注する際、委託先が何らかの形で生成AIを活用している可能性は高いと言えるでしょう。

そのため、外部パートナーに制作を依頼する場合は、以下の確認項目を押さえることで品質リスクを最小化することが重要です。

外注先がAI活用方針や品質管理プロセスを事前に把握し、適切な体制が整っているかを見極めることが、最終的なコンテンツの信頼性を確保するポイントとなります。

ファクトチェック体制の透明性

外注先との契約時には「AIの利用状況」と「品質管理プロセス」の確認が不可欠です。具体的には、AIと人間による二段階確認体制の有無、一次情報の出典明示ルールなどが重要な評価基準となります。これらの透明性が高いほど、最終成果物の信頼性も向上します。

専門知識によるレビュー体制

特に医療・法律・金融などの専門分野では、誤った情報が重大な影響を及ぼす可能性があります。訴訟問題に発展した場合、その損害は計り知れません。

外注先に専門知識を持つレビュアーが在籍しているか、専門的見地からの監修体制が整っているかを確認することで、専門性の高いコンテンツでも安心して発信できるでしょう。

正確性と効率性の最適解を求めて

BBCの調査結果は私たちに明確なメッセージを送っています。生成AIがニュース要約で重大な誤りを含む現実は、もはや見過ごせない段階に来ているのです。企業ブランドの価値と社会の信頼を守るためには、AIのみに依存する姿勢を改め、人間の目による緻密な確認プロセスを確実に組み込むことが不可欠です。

しかし同時に、AIがもたらす圧倒的な処理速度とスケールの利点も無視できません。GoogleのDataGemmaやRAG技術の進化は、AIが外部証拠と連携して自己検証能力を高める新たな可能性を示しています。これからの情報産業では、AIの分析力と処理スピードに人間の批判的思考と文脈理解を組み合わせた「デジタルとアナログの知性の交響曲」が標準となるでしょう。

企業の広報・マーケティング担当者には、ファクトチェックという防波堤の強度や専門家レビューという安全網の質を基準に、パートナーを戦略的に選定することを強く推奨します。この一手が、ブランドの信頼性と読者との関係を長期的に守る鍵となります。

テクノロジーの限界を正しく認識しながらその強みを最大限に引き出すバランス感覚こそが、正確で価値あるコンテンツを生み出す源泉となるのです。多層的な検証システムを備えた情報発信体制の構築は、現代のビジネスコミュニケーションにおいて、もはや選択肢ではなく必須条件と言えるでしょう。

この記事を書いた人

雨輝編集部

「品質重視」「成果戦略」「価値創造」の理念をもとに媒体の垣根を超えて、"今"と"これから"読まれるコンテンツづくりを追求し続ける編プロ。記事づくりではなく、メディア戦略から、創造性に富んだ企画、最新のSEO対策、AI時代に適したマーケティングまで幅広い範囲で企業をサポートしています。