「猿がタイプライターを叩き続ければシェイクスピアの作品が生まれる」——このような例え話が確率論の世界にありますが、生成AIの登場によって、ボタンひとつで実現しそうな世の中になってきました。

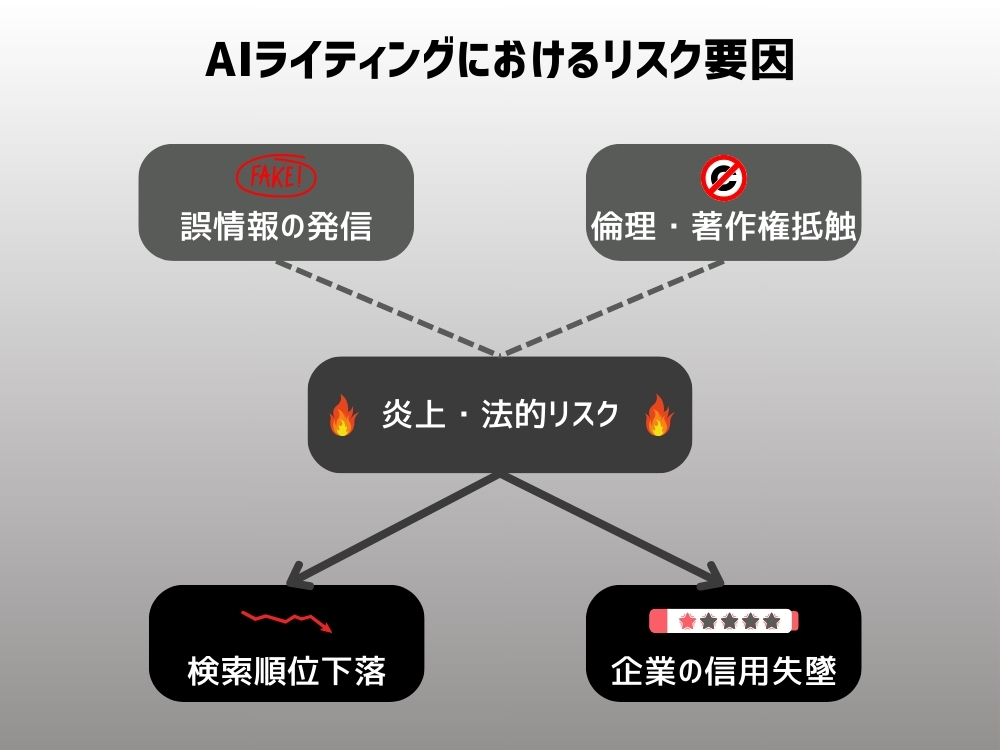

ChatGPTを筆頭とした生成AIツールの登場は、文章制作のスピード感を一気に跳ね上げました。しかし、人命や企業イメージに関わる“重要コンテンツ”まで機械任せにしてしまうのは、まるで自動運転の車に「ブレーキ不要だよね?」と言ってハンドルを渡すような危うさが潜んでいます。誤情報・著作権侵害・炎上といったリスクが表面化するのも時間の問題です。

本記事では、AIと人間の役割分担をはっきりさせることがいかに大切か、そしてプロの編集力を掛け合わせることで高品質コンテンツを生み出すための具体的なポイントを解説していきます。

AIライティングの急速な普及と、その裏にあるリスク

「ローマは一日にして成らず」という言葉がありますが、AIライティングの世界は、ローマどころか銀河帝国だって一日で築けそうな勢いで賑わっています。その圧倒的なスピードと効率化の裏で、私たちは多くのものを見落とすリスクをはらんでいます。

AIツールが広げた可能性と課題

AIライティングツールは、定型の調査や文章をわずかな時間でこなせる“文明の利器”です。ChatGPTのような先端ツールなら、社員が数日かけて下調べする作業をあっという間に済ませてくれます。

- SNS投稿の下書き

- 新商品の説明文のたたき台

といった用途には大きなメリットがある一方、魔法の杖を振りかざすようにAIを使うと、そこに古い情報”や“誤ったデータ”が混在している危険性も無視できません。医療や金融など、専門性の高いテーマで長文コンテンツを生成させると、学習データの古さや文脈の誤解が原因で、正確性に欠けるケースが多々発生します。

専門分野の執筆を安易にAIへ投げた結果、デマが“高速”で拡散されると、企業ブランド全体の信用を一瞬で失うリスクがあるのです。

人的リサーチや校正が不可欠な理由

長文コンテンツや専門領域の記事では、最終的に「この情報は正しいか?」を確かめるのは人間しかできません。AIはインターネット上のデータを大量にかき集めるものの、その信頼性までは保障してくれないからです。

2016年に問題となった医療サイト「WELQ」では、専門知識のないライターが大量の医療・健康系記事を作成し、その正確性をろくにチェックしなかったことで大規模な批判と信用失墜を招きました。同様の手法を、もし今の生成AIに任せっきりで行えば、同レベル、あるいはそれ以上の炎上が起こっても不思議ではありません。

(参考リンク: 「炎上」が暴いたDeNA劣悪メディアの仕掛け)

AIライティングが得意とする業務とは

「それでもAIを活用して作業を効率化したい」というのが、多くの企業の本音でしょう。では、具体的にどんな業務ならリスクを抑えながらAIを活かせるのか?ここではビジネス現場での代表的なユースケースをご紹介します。

短文・定型コンテンツの効率化

AIライティングの強みが最も発揮されるのは、短い文章や定型的な文面を大量に作成する場面です。

例えばECサイトの商品紹介文やSNSのキャンペーン告知などは、AIを活用すれば下書きのスピードが格段に上がります。その後、人間がスペックの誤りや表記ゆれを確認すれば、スタッフの労力を大幅に削減できるでしょう。

ただし「AIが90%正しい情報をアウトプットしてくれる」場合でも、残り10%のミスが致命的である可能性を忘れてはいけません。

アイデアのブレストやトレンド調査

AIはありとあらゆるキーワードを瞬時にスキャンし、ざっくりとしたトレンドやアイデアの種を投げ込んでくれます。

「最近はこんな検索キーワードが伸びている」「これとこれを組み合わせたら面白そう」といったブレストの段階では有用なアシスタントとなるでしょう。ただし、そのアイデアを実際のコンテンツに落とし込むには、追加のリサーチや事実確認が欠かせません。専門性の高い記事を書く場合には、より深い裏付けが必要なのです。

AIライティングに潜むリスクと実例

AIを使えば長文だって楽勝……と思いきや、誤情報や炎上の火種が潜んでいるかもしれません。ここでは、実際に起きたトラブル事例を取り上げながら、気をつけるべきポイントを見てみましょう。

誤情報の拡散によるトラブル〜ワイオミング州の新聞社の事例〜

2024年、アメリカの地方新聞社で衝撃的な事件が起きました。ワイオミング州の新聞社「Cody Enterprise」の新人記者が、AIを使って架空のインタビュー記事を作成していたことが発覚したのです。

問題となった記事では、州知事をはじめとする複数の人物の「発言」が掲載されていましたが、実際には一度も取材が行われていませんでした。AIが生成した架空の発言を、あたかも実際のインタビューであるかのように記事に使用していたのです。

このような、AIが事実に基づかない情報を生成してしまう現象は「ハルシネーション(幻覚)」と呼ばれています。しかし、今回の事例は単なるAIの技術的な問題ではありません。ジャーナリストが意図的にAIを使って虚偽の記事を作成したという、報道倫理に関わる重大な問題でした。

この事件により、Cody Enterpriseは読者からの信頼を大きく損ねることとなりました。創刊125年の歴史を持つ地域の信頼される新聞社が、一瞬にして信用を失うことになってしまったのです。

医療などの分野なら、こうした“虚偽情報”がさらなる大きなトラブルを招きかねません。ろくにチェックしないままAI生成の文章を掲載すれば、WELQ問題の再来は時間の問題といえるでしょう。

(参考リンク: AI Scandal Hits Wyo. Paper)

著作権侵害やプライバシーの問題〜3つの事例〜

New York Timesによる訴訟事例

New York Timesは2023年末、OpenAIとMicrosoftに対して著作権侵害訴訟を起こしています。この訴訟の核心は、ChatGPTが同社の記事を許可なく丸ごとコピーしているという点です。

具体的な証拠として、2012年のテクノロジー企業に関する特集から9段落もの文章を逐語的にコピーしていた事例や、2019年のタクシー業界に関する記事を最小限の書き換えだけで流用していた事例が示されています。

これは単なる事実やアイデアの借用を超えた、明確な著作権侵害であるとNew York Timesは主張しています。

(参考リンク: Why The New York Times AI Case is Different)

レビュー生成による問題事例

また、Rytrは、簡単な操作で”本物らしい”詳細なレビューを生成できる優れたサービスで知られていました。しかし、2024年9月、米連邦取引委員会(FTC)がAIを活用したレビュー生成サービスを提供するRytr LLCに対して規制措置を講じることを決定。

このサービスを通じて数万件のレビューが生成されたことから、FTCはこれらの偽装レビューが市場を汚染し、消費者に実質的な被害をもたらすと判断したのです。

(参考リンク: FTC Brings Case Against AI-generated Reviews Company, Over Strenuous Dissent)

ポリコレが関連した問題事例

Googleが開発したAI画像生成ツール「Imagen」が、特定の人種や性別に偏った画像を生成したとして問題になった事例もあります。具体的には、歴史上の人物を描写する際に、黒人のナチス兵士や女性のローマ教皇など、歴史的に不正確な画像を生成し、批判を受けました。

この問題を受け、Googleは「Imagen」の人物画像生成機能を一時停止し、改善に取り組むと発表する形となっています。

「短文だから大丈夫だろう」と思ってコピペ状態に近い文章を公開すれば、著作権問題や倫理的な観点からトラブルになるリスクは低くありません。個人情報を扱う場合にはプライバシー侵害の危険性も無視できません。

(参考リンク: グーグル、対話型AIで人物の画像生成を停止 人種的な偏りが原因か)

企業イメージへの悪影響〜2つの事例〜

AIによる不自然な文章で信頼を失った事例

アメリカの大手新聞社ガネットが高校スポーツ記事をAIツール「Lede AI」に執筆させたところ、不自然な文章や誤りの多さを読者に指摘され、実験を中断せざるを得なくなりました。

さらに、同年11月にはスポーツ雑誌『Sports Illustrated』が“架空の記者名”と“AI生成写真”を使って記事を掲載していたことが発覚し、「それ、やる意味あるの?」と読者の不信感を増幅。ブランドに深い傷を残す結果となりました。

(参考リンク: Gannett halts AI-written sports recaps after readers mocked the stories)

品質や正確性を怠ったことから罰金を科された事例

DoNotPayの“ロボット弁護士”が、AIの限界を超えた宣伝が問題視され、米国連邦取引委員会(FTC)から19万3,000ドルもの罰金を科された事例があります。

この事例は、FTCが開始した「Operation AI Comply」と呼ばれる新たな法執行活動の一環です。DoNotPayは「2000億ドル規模の法律業界をAIで置き換える」と謳い、人間の弁護士の専門知識や成果物を代替できると主張していましたが、FTCによれば、これらの主張を裏付ける検証は一切行われていませんでした。同社は法律の専門家を雇用せず、サービスの品質や正確性も確認していなかったことが明らかになりました。

(参考リンク: ‘Robot lawyer’ company faces $193,000 fine as part of FTC’s AI crackdown)

人的リサーチ・校正が不可欠な理由

専門知識が必要な分野や長文のコンテンツほど、AIだけに任せるのは危険度が跳ね上がります。最終的に「これは本当に正しいか?」を判断し、品質を整えるのはあくまで人間だからです。

リサーチの深みはAIだけでは補えない

専門家へのインタビューや学術論文の読み込みなど、“本格リサーチ”はAI任せにできない部分が多々あります。AIが90%正しくても、10%の誤りが致命的になるリスクは大きいもの。

「10%の確率で間違えるExcelが存在したらあなたは使いますか?」と問われれば、多くの人が「怖くて使えない」と答えるでしょう。AIを100%に近づける工夫こそ、コンテンツ制作において不可欠なプロセスです。

トーン&マナーを守る文章校正

AIは辞書的な知識を引き出すのは得意ですが、「読者の心を動かす感情表現」や「ブランドならではの文体」を再現するのは苦手。

たとえば「感謝の言葉」一つ取っても、フランクに伝えたいのかビジネスライクにまとめたいのかで使うフレーズは大きく変わります。だからこそ、人間の視点で文章のトーンや表現を整える作業が必要不可欠なのです。

企業担当者が押さえておくべき注意点

生成AIを活用するにあたって、単に「AIでラクできる」では済まされません。社内全体でルールを徹底し、最終チェックの体制をどうするかあらかじめ決めておく必要があります。

ガイドラインの整備とチェック体制

「AIが作成した文章は安易に公開しない」「必ずプロや担当者が最終校正をする」といった社内ルールを明文化することがカギです。万が一誤情報をリリースしてしまった場合の修正・謝罪フローも事前に用意しておけば、ダメージを最小限に留められます。

SEOへの配慮とオリジナル性確保

GoogleはAI生成コンテンツの重複率を厳しくチェックし始めています。たとえば重複判定を受けやすいAI文章は検索順位を下げられる可能性があり、実際にRedditなど大規模プラットフォームで順位下落の報告があります。

専門家の監修を入れながら独自の見解や実例を盛り込み、“AIに書かせるだけでは出せないオリジナリティ”を発揮することが、結局はSEO評価を高める近道にもなります。

(参考リンク: Reddit’s Google Rankings Drop: What’s Behind It?)

(参考リンク: AI 生成コンテンツに関する Google 検索のガイダンス)

専門家・ファクト重視の外注先との連携

外部に制作を依頼する場合でも、どのようにファクトチェックを行い、AIと人間を使い分けているかを事前に確認しましょう。世の中には実際は下請けやAIに丸投げしているのに「高品質」をうたう制作会社も存在します。

本当に専門知識を持つ人が監修しているのか、どんなプロセスで校正が行われるのかをしっかりチェックすることで、ブランド価値を毀損しないコンテンツを手に入れられるでしょう。

AIと人間の「使い分け」で質の高いコンテンツを

かつてスマートフォンが登場した時、「これで誰でもプロカメラマンになれる」と言われました。しかし実際には、テクノロジーは表現の可能性を広げはしても、プロの技術や判断力に取って代わることはありませんでした。

AIは確かに驚くべき効率化をもたらしてくれますが、それは「プロの仕事」を完全に代替するものではありません。特に専門性の高い分野では、バイアスや誤情報を排除するためのリサーチ、ブランドに合った文体への仕上げなど、人間の手がこれまで以上に重要になってきています。

デジタルとアナログ、AIと人間――この二つの歯車がかみ合ってこそ、真に価値のあるコンテンツは生まれるのです。賢明な使い分けこそが、デジタル時代を生き抜くための必須スキルなのかもしれません。

この記事を書いた人

雨輝編集部

「品質重視」「成果戦略」「価値創造」の理念をもとに媒体の垣根を超えて、"今"と"これから"読まれるコンテンツづくりを追求し続ける編プロ。記事づくりではなく、メディア戦略から、創造性に富んだ企画、最新のSEO対策、AI時代に適したマーケティングまで幅広い範囲で企業をサポートしています。